Нейронка + вики - базовый логический каскад

kvisaz — 16.11.2024

kvisaz — 16.11.2024

В общем, понятно, что софт "нейронка" + "вики" - это тот

минимальный комплект, который уверенно бы решил проблему и с кучей

галлюцинаций, и с недостаточностью знаний в моделях.

Откуда мне взять столько митохондрий, сахара или что там требуется

для дикой умственной работы, чтобы реализовать все эти простые

программы? Остается надеяться, что из всех миллиардов найдется хотя

бы один азиат, которые наберет на своей печатной машинке этот

простой рецепт.

Мысли вслух, не обращайте. Я все еще в шоке от того, что RAG - это

нечеткий поиск, то есть весьма узкий инструмент. Давайте все по

новой, давайте к корням и точный поиск вхождения.

Вот так я вижу примерный алгоритм "нейронного чата с

вики-накачкой":

1. Обработка ключевиков из изначального промпта юзера

классическое программирование: Любой ввод юзера

оборачивается в тег SRC (выбор имени тега условен), и предваряется

инструкцией

- выдели самые важные ключевые слова из запроса внутри тега SRC и

выведи их списком

Нейронка: выделяет список.

2. Поиск данных для обогащения промпта

классическое программирование: список вычленяется и слово за

словом формирует подборку статей из Википедии по ключевикам

3. Обработка данных для промпта

классическое программирование: размер статей

сравнивается с размером контекстного окна модели в текущем чате и

если они превышают некоторый процент (надо же еще резервировать под

другие пункты и ответ), то каждая статья отдельно кидается в

нейронку, можно эту же, с командой "краткий пересказ с

существенными фактами". Или вообще "список важнейших фактов и

цифр".

Нейронка: выделяет список.

4. Обогащение изначального промпта

классическое программирование: изначальный запрос

юзера из тега SRCв п.1 снова кладется в тег , к нему идет подводка-

ответь на запрос юзера в теге src, используя свои знания, а также

факты из тега DATA

В DATA вкладываются статьи из вики или их краткая сумма.

5. Ответ нейронки на обогащенный промпт

Нейронка: отвечает по обогащенному промпту.

Ответ будет каким угодно, но не таким, что "Колобок - известная

поэма Салтыкова Щедрина" или "Я не могу рассуждать о Штирлице, так

как это включает в себя неприятные исторические факты", которые

характерны были в 2022 для GPT 3.5, а сейчас для малых домашних

нейронок.

Вы спросите, что насчет вырождения чата?

Вырождение чата, дорогие мои юзеры современных чатов, происходит

от того, что почти все текущие диалоги с нейронкой строятся по

простой схеме "все предыдущие вопросы юзера и ответы нейронки -

снова отправляются ей на вход". Поэтому рано или поздно

нейронка, созданная изначально для продолжения текста, начинает

сходить с ума или тупеть под влиянием колоссальной истории чата с

вопросами и ответов.

Схема, которая описана выше - это "базовый транзисторный каскад",

который гарантирует очистку от шумов и защиту от подобных

галлюцинаций, так как она не подразумевает повторную отправку

вопросов и ответов с каждым новым вопросом.

Но если нужны длинные беседы, то уверен, написать похожие каскады,

которые будут

- вычищать из старых вопросов юзера мусор и оставлять только

наиболее важные

- включать в отправку предыдущий ответ нейронки только если в теге

src будет команда со ссылкой на предыдущий текст (на это надо будет

написать отдельный логический каскад)

Вот вам, computing over learning, вот вам перенос тяжести с

обучения на синекдоху отвечания, вот вам медленное мышление

нейронки и поощрение классических методов поиска информации и

работы с базами данных.

Но если я сойду с ума, чтобы писать самому такое, я сначала напишу

автоматического блоггера-новостника.

PS: термин "каскад" по сути означает "ступень" или "шаг", потому "логический каскад" представляется удачным, как "каскады в электронике"

Большие займы в Краснодар на выгодных условиях: как найти лучшие предложения без переплат

Большие займы в Краснодар на выгодных условиях: как найти лучшие предложения без переплат  Бобр!!!

Бобр!!!  Мои приобретения для коллекции: Франция - 80 лет победы во Второй мировой войне

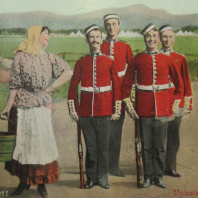

Мои приобретения для коллекции: Франция - 80 лет победы во Второй мировой войне  Трое с тросточками, не считая служанки.

Трое с тросточками, не считая служанки.  Герасимов раскрыл карты.

Герасимов раскрыл карты.  Плов — любимое блюдо россиян

Плов — любимое блюдо россиян  Шанхайское метро

Шанхайское метро  Армения - Россия: начало развода?..

Армения - Россия: начало развода?..  Ничто не может остановить то, что грядет

Ничто не может остановить то, что грядет