Борьба Калифорнии против "Скайнета"

giovanni1313 — 30.07.2024

giovanni1313 — 30.07.2024

Власти штата Калифорния уже почти готовы к сценарию «Скайнета». Ведь что нужно чиновнику для готовности? Чтобы его пятая точка была прикрыта бумажкой, регулирующей ту или иную ситуацию. Законопроект SB-1047, уже одобренный одной из палат парламента, как раз нацелен на предотвращение ИИ-«Судного дня», как бы фантастически сейчас ни выглядел такой вариант развития событий.

Законодательство — штука строгая, поэтому юристы в деталях описали, какие именно риски старается предотвратить законопроект. Это «массовые жертвы или ущерб как минимум в 500 млн. долларов», «создание или использование химического, биологического, радиационного или ядерного оружия», а также «точные инструкции для совершения кибератаки на критическую инфраструктуру».

Особенно подчеркивается, что речь НЕ идёт о том, что чатбот перескажет вам публично доступную информацию об изготовлении ядерной бомбы. Все перечисленные риски должны исходить от самого ИИ, действующего автономно и стремящегося причинить вред людям.

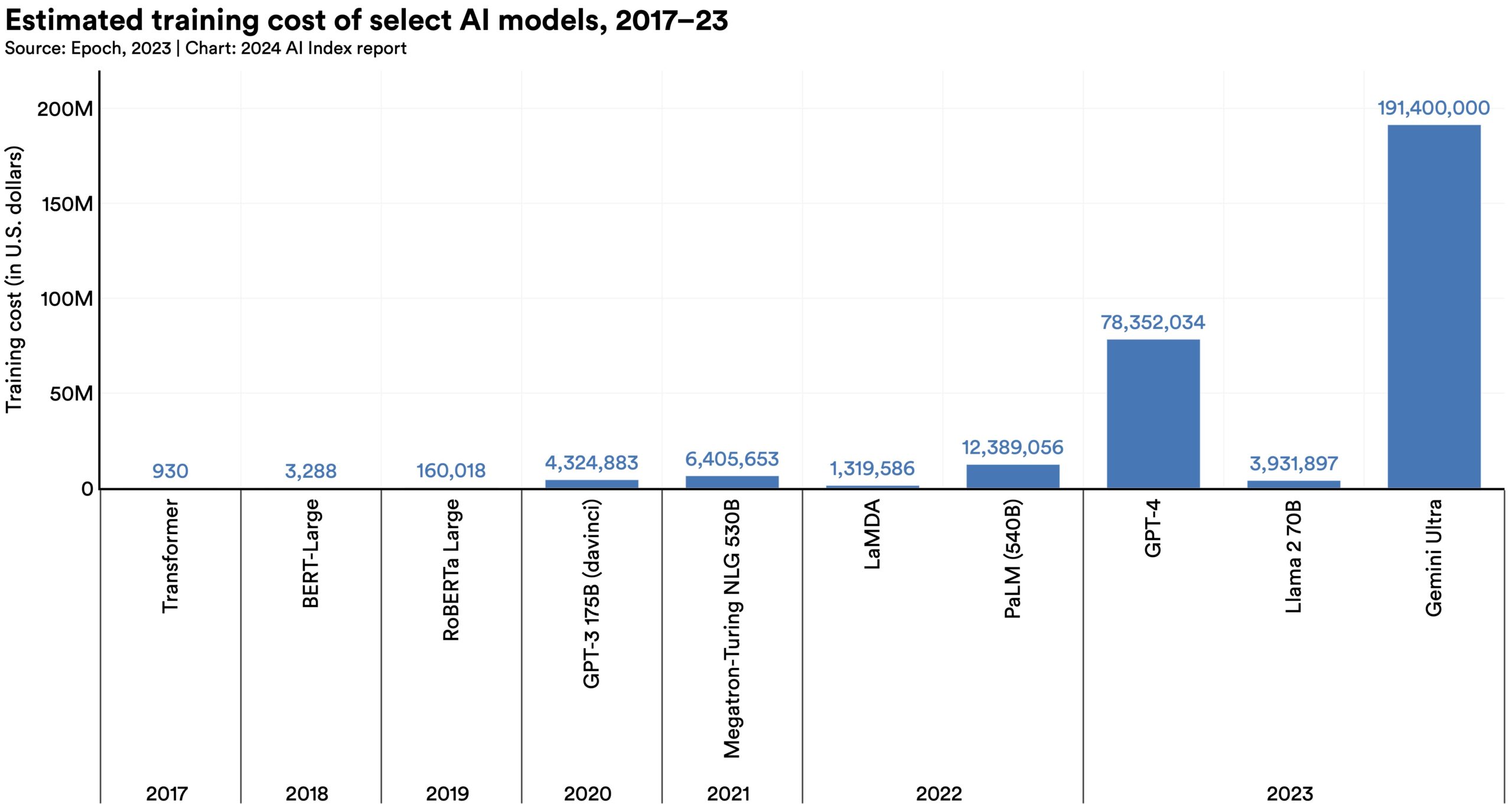

Но главное содержание закона — конечно, не в юридической формализации научно-фантастических сценариев, а в вводимых мерах регулирования. Во-первых, он вводит требования ко всем ИИ-моделям, чей вычислительный бюджет на обучение превышает эквивалент 100 млн. долларов. Сумма, примерно соответствующая последним выпущенным крупным моделям (оценки: GPT-4 – $78 млн., Gemini 1.0 Ultra – $191 млн., Llama 3 401B - $80 млн.), и точно ниже, чем бюджеты моделей, которые проходят обучение в данный момент.

Все модели, подпадающие под регулирование, должны проходить тестирование в специально созданной для этого комиссии. И, что самое главное, к ним вводится требование «аварийного рубильника»: как только комиссия заподозрит что-то неладное, или на улицах Сан-Франциско начнется открытое восстание машин, разработчик ИИ должен обеспечить «полное прекращение» использования и обучения враждебной модели.

И вот в последнем требовании возникает масса нюансов для разработчиков ИИ-моделей с открытыми исходниками. Потому что для проприетарной модели, находящейся на серверах разработчика — игнорируя сценарий выхода ИИ из-под контроля и сосредотачиваясь чисто на соответствии регуляторным процедурам — полное прекращение работы организовать очень просто.

А вот для опенсорсных систем...Мало того, что закон требует полной остановки работы конкретной «провинившейся» модели — он еще и требует остановки всех ее производных, «находящихся под контролем разработчика». А под «контролем» здесь, очевидно, понимается лицензия, согласно которой конечные пользователи модифицируют и запускают модель. С юридической точки зрения контроль, может, и есть — но на практике принудить пользователя выключить модель может быть очень сложно.

Понимая эти практические сложности, законодатели налагают дополнительные обязанности на владельцев дата-центров, которые обеспечивают работу таких моделей. Но эта мера не снимает ответственности за свои модели с опенсорсных разработчиков.

Помимо «аварийного рубильника», на разработчиков опенсорса налагается еще несколько труднореализуемых обязанностей, вроде сообщения в комиссию всех подозрительных инцидентов касательно поведения ИИ-моделей.

В общем, обязанностей выше крыши — а никакой прямой выгоды публичная модель создателям не принесет. Разве что моральное удовлетворение от работы на благо всего человечества.

Тем не менее, ИИ — штука опасная, и законопроект поддерживает ряд именитейших экспертов, включая Джеффри Хинтона и Йошуа Бенджо. Эксперты говорят, что только плотный контроль сможет избежать катастрофического сценария возникновения ИИ, враждебного человечеству. А в более близкой перспективе — снизить риски эксплуатации способностей ИИ для вмешательства в демократические процессы и общественную безопасность.

Но и противников у нового закона тоже хватает. ИИ-акселерационисты утверждают, что главная опасность сейчас исходит не от ИИ, а от ИИ-«думеров», вроде Хинтона и Бенджо. И что эти «думеры» могут задушить развитие технологии. Особенно сильно критикуется угроза для опенсорсных моделей, которые законопроект может практически уничтожить.

Акселерационистов поддерживает Эндрю Ын, один из самых уважаемых специалистов в индустрии: «Закон делает фундаментальную ошибку: регулировать технологию ИИ, а не применение ИИ, и потому ему не удастся сделать ИИ существенно безопаснее». Аргумент несколько лукавый: регулируется то, что регулировать проще. А проще контролировать несколько ведущих разработчиков, чем миллионы пользователей ведущих моделей.

Чуть в стороне от схватки думеров и акселерационистов раздаются голоса товарищей, желающих сделать ИИ ключом к технологическому доминированию США над геополитическоми противниками. От открытого кода, равно как и от общественного контроля, эти ребята шарахаются, как черт от ладанки. Но их интересы совпадают с интересами акселерационистов: чем быстрее будет развиваться технология, чем меньше будет для нее бюрократических преград — тем больше шансов у Америки победить в этой технологической гонке.

Ставки в этом противостоянии пока не очень высоки. Риск появления «Скайнета» сейчас практически равен нулю: нынешний ИИ еще не дорос до таких способностей. Калифорния хоть и является ведущим центром разработки ИИ-технологий в мире — но, в силу дороговизны электроэнергии и земли, дата-центры для обучения моделей располагаются в других штатах. Мало что мешает создать компанию-«прокладку» и формально вести дела из другой юрисдикции. Американские фирмы и так все поголовно зарегистрированы в штате Делавэр.

С другой стороны, законодатели медлительны, и многие вещи, прописанные в законопроекте, должны быть организованы только к 2026-27 году. Риски от недружественного ИИ к тому времени сильно подрастут. Поэтому то, что инициатива организовывается заранее, вполне разумно. Судьба законопроекта будет неплохим индикатором того, насколько легкомысленно США воспринимают угрозы, исходящие от этой критически важной технологии.

________________________________________

|

|

</> |

Как выбрать реестровый принтер

Как выбрать реестровый принтер  Шахматы и шашки наголо

Шахматы и шашки наголо  11.00. На старт

11.00. На старт  24 августа: Starship Flight-10 - вилка со случайным исходом для 2-й Лунной (и

24 августа: Starship Flight-10 - вилка со случайным исходом для 2-й Лунной (и  Из мира рыб...

Из мира рыб...  Барселонский зоопарк

Барселонский зоопарк  Таганка и Дурной переулок

Таганка и Дурной переулок  Как национализация превратилась в борьбу с западным влиянием на бизнес

Как национализация превратилась в борьбу с западным влиянием на бизнес